dg2

-

Compteur de contenus

1 436 -

Inscription

-

Dernière visite

-

Jours gagnés

6 -

Last Connexion

Soon available - 42142

Messages posté(e)s par dg2

-

-

Samedi prochain (le 4) aura lieu à partir de 19h30 la 4e nuit de l'astronomie à l'institut d'astrophysique de Paris (dans le 14e arrondissement, juste à côté de l'observatoire). Sur place auront lieu 5 heures de conférences diverses et variées centrées sur la cosmologie et la mécanique quantique, ainsi que des rencontres avec des étudiants et chercheurs. Le maître de cérémonie sera le journaliste scientifique Mathieu Grousson, accompagné de quelques live-sketchers spécialisés en science.

Le programme est ici :

https://www.iap.fr/actualites/laune/2022/mai/nuit-astro-fr.html

C'est gratuit, mais il faut impérativement réserver avant de venir (https://www.weezevent.com/widget_billeterie.php?id_evenement=846249&widget_key=E846249&locale=fr_FR&color_primary=00AEEF&code=48385&width_auto=1) car le nombre de places est limité. Pour les non franciliens, le tout peut être suivi en ligne sur YouTube :

-

5

-

6

6

-

-

Il y a 4 heures, Daniel Bourgues a dit :Et là même si on affine les mesure, ces objets resteront bien malgré tout les plus distants visibles à l’œil nu

Surpassés cependant par M81 lorsque les conditions sont optimales (sujet plusieurs fois abordé ici).

-

3

3

-

-

Il y a 3 heures, Bruno- a dit :(Je ne crois pas que la supernova de M31, au dix-neuvième siècle, ait été vue à l'œil nu, à moins que je me trompe ?)

Si, elle l'a été, mais comme la supernova était située vraiment au centre de M31 (à 15 secondes d'arc, de mémoire), l'impression visuelle était plutôt que M31 était globalement un peu plus brillante plutôt que celle d'un astre supplémentaire.

-

2

-

1

1

-

-

Il y a 10 heures, Superfulgur a dit :Si c'est vrai (perso, en l'écoutant, j'entend que du chwouin gome, pourtant, je suis super fluent en english (are you ? You are, but alors...) si c'est vrai, donc, ça fait une mag absolue de 0 environ...

En gros, le truc brillerait comme Vega, une étoile brillante... Ca me semble très peu.

Il faudrait que des fusées, genre @dg2 et companie, viennent nous espiquer. Peut-être la masse de plasma en rotation est elle finalement assez faible, et, comme la couronne solaire, malgré sa température, brillerait finalement peu.

Sgr A* est le trou noir le moins actif connu (et oui, c'est pas de bol). Pour un trou noir de masse donnée, sa luminosité d'accrétion maximale est de 30000 luminosités solaires par masse solaire. Avec Sgr A* on est à 4 millions de masses solaires, mais sa luminosité (contraintes probablement via des mesures IR et X, non atténuées par le milieu interstellaire) est au plus un milliardième de sa luminosité max., soit 30000 x 4 x 106 x 10-9 = 120 luminosités solaires. Donc cela complique la donne. Mais au moins quand on vous dit qu'on voit des étoiles très lumineuses tourner autour de rien du tout ,on ne raconte pas d'âneries.

Attention cependant, l'émission radio est non thermique, donc pour un truc en radio cela reste assez intense.

-

1

-

5

5

-

-

Il y a 4 heures, Superfulgur a dit :Du coup, je suis mal à l'aise avec les intensités radio, je suppose qu'on peut dire que la "magnitude millimétrique" du trou noir est gigantesque ?

La température de brillance se compte en dizaines de milliards de degrés, donc c'est beaucoup (quoique moins que des quasars et autres trucs très actifs). Cela signifie que le truc crache autant en radio qu'un corps noir de 1010 K ne cracherait en radio. Bien sûr le disque n'est pas à une telle température (plutôt 106 K max pour un trou noir de cette masse, et bien moins ici car ce TN est assez peu actif), c'est juste que les phénomènes radio dus à diverses causes sont très importants.

-

1

-

4

4

-

-

Il y a 2 heures, AlSvartr a dit :Donc pour le dire autrement, avoir le disque d'accrétion coïncidant avec le plan galactique permet d'exclure la possibilité d'une fusion passée de TN supermassifs avec un bon niveau de confiance.

Je ne dirais pas cela, une telle configuration ne permettrait simplement pas de conclure. Car il ne fait quand même guère de doute qu'une galaxie comme la Voie lactée est issue de fusions successives de galaxies de plus petite taille. C'est ce que disent tous les modèles de formation des grandes structures et on peut vérifier explicitement que les étoiles de notre halo galactique gardent la trace dynamique de six fusions galactiques passées. La plupart de ces fusions étaient d'ailleurs identifiées avant Gaia, qui a affiné la chose et détecté la trace d'une autre fusion, plus un possible 7e candidat, cf. https://arxiv.org/abs/2202.07660.

-

3

-

-

Il y a 5 heures, Optrolight a dit :Si j'ai compris dans la conf que SAG A* était presque vue de face alors que M87* est vu plus de biais

Les deux sont vus en incidence plutôt normale. On le sait depuis longtemps pour M87 (le jet émanant de la galaxie pointe vers nous, d'où le fait qu'on ne voit pas le contre-jet, beaucoup trop atténué car redshifté). C'est un peu surprenant pour Sgr A* car on se serait plutôt attendu que son axe de rotation soit perpendiculaire au plan galactique mais ça n'est pas le cas (écart de 60° environ, dans la limite où l'imagerie confirme l'inclinaison préalablement estimée). Mais les modèles de fusions galactiques expliquent je crois qu'une partie importante du moment cinétique des TN supermassifs est dû au moment cinétique orbital du couple qu'il a formé avec un autre TN supermassif lors d'une fusion galactique, et que ce plan orbital-là n'a rigoureusement aucune raison d'être corrélé avec l'orientation des galaxies avant ou après fusion.

-

4

-

8

8

-

-

Il y a 4 heures, Gribol a dit :Je me pose la question de la résistance d'une électronique à un nombre de g faramineux.

Sur cet article: https://www.futura-sciences.com/sciences/breves/espace-vol-bolide-lance-1600-km-h-centrifugeuse-spinlaunch-vu-interieur-6419/#xtor%3DRSS-8

Il est question de 9.000 à 10.000 g.

J'imagine que les ingénieurs du concept ont réfléchi à la question.

Il faut garder en tête que si on modélise un électron (masse m, charge q) dans le cadre d'un atome de Bohr, alors l'électron en question parcourt une orbite de rayon R égale à, disons, 0,05 nm, et il le fait suivant l'équivalent électromagnétique de la troisième loi de Kepler, soit

v2R = q2 / 4 π ε0m,

soit une vitesse v égale à quelques pourcents de la vitesse de la lumière, et une accélération de v2 / R = v2R / R2 = q2 / 4 π ε0m R2,

soit, à la louche, dans les... 1022 g (c'est bien 10 puissance 22). Donc si on lui rajoute 10000 g = 104 g, l'électron a peu de chances d'être décoiffé. La problématique n'est sans doute pas dans l'électronique elle-même, mais dans la résistance mécanique des différents éléments, électroniques ou pas.

-

2

-

3

3

-

-

Il y a 3 heures, brizhell a dit :Les lentilles gravitationnelles prévues par Zwicky en 1937 n'ont été observée que dans les années 70 non parce que l'on a augmenté la surface collectrice, mais parce que le pouvoir séparateur résolvait sans ambiguïté deux sources de mag 16.7 séparées de 6".

Oui mais non. Le quasar double a été découvert... parce que c'était un quasar double et qu'il était curieux (statistiquement parlant) qu'on ait deux radiosources aussi brillantes aussi proches. À partir du moment où on a détecté cette anomalie en radio, on y a regardé de plus près. Je ne pense pas que la résolution en visible ait joué un rôle.

-

2

-

1

1

-

-

il y a 3 minutes, Huitzilopochtli a dit :Cependant, aux basses latitudes (à moins de 45°) un point de visé ne sera accessible que lors de deux périodes, tout les six mois, et ne durerait qu'une cinquantaine de jour si mes souvenirs sont bons.

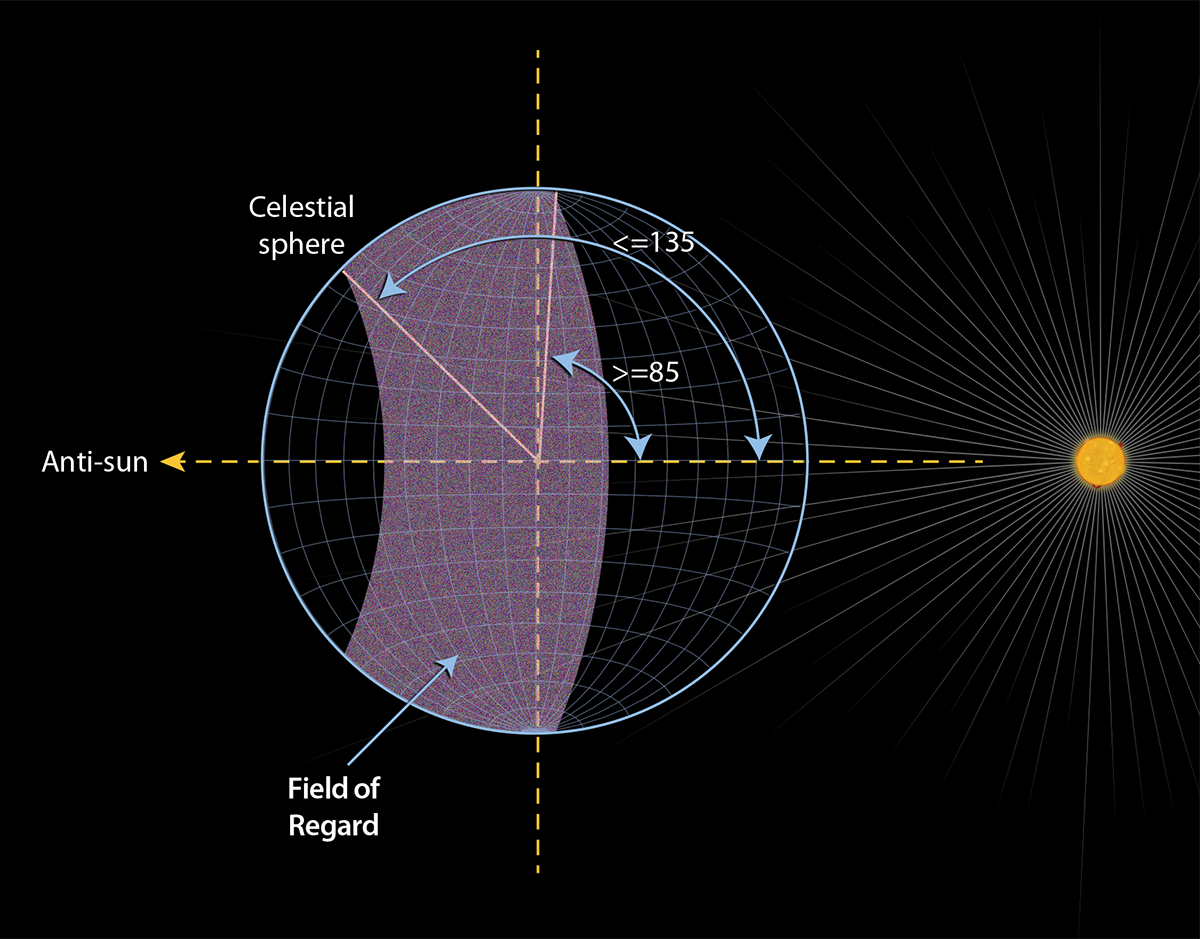

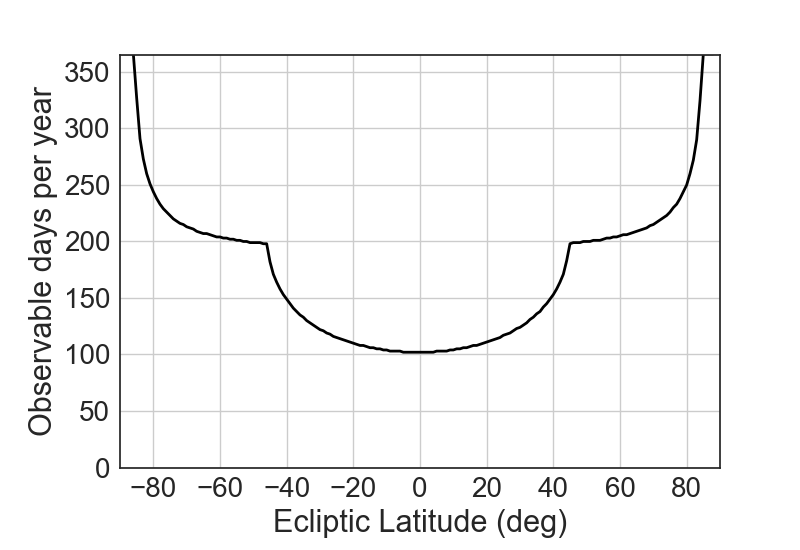

Si on se fie au schéma, est pointable toute cible située entre 85° et 135° du Soleil, ce qui, dans le cas d'une cible sur l'écliptique correspond à deux périodes de 50° de l'orbite, donc un poil moins que 50 jours. Plus la latitude augmente, plus la cible est pointable pendant longtemps, soit sur deux périodes (moins de 45° de latitude), soit en continu pendant une seule période. Une cible à plus de 85° de l'latitude écliptique est pointable en permanence.

Il me semble cependant qu'il existe des contraintes supplémentaires car le pare-Soleil a une efficacité variable en fonction de l'angle qu'il fait avec le Soleil et qu'il n'est pas possible de pointer en continu une cible pendant toute sa période d'observabilité potentielle.

-

1

-

3

3

-

-

Il y a 4 heures, Pulsarx a dit :Ca couterait combien à la méga louche (des millions, des 10aines de millions, des 100aine, ...) de lancer des petits satellites dont le seul but est de se mettre en orbite et de photographier en haute résolution tout un paquet de cibles peu explorées (Uranus etc)

Pour Galileo et Cassini, la moitié de la masse de la sonde était du carburant. Au-delà de Jupiter, la seule source d'énergie et un générateur électrique à radioisotopes qui ne fonctionne qu'avec du plutonium-238, plutonium-238 dont les USA ne possèdent que quelques kilos et une capacité de production quasi-nulle (ils l'importaient de Russie jusqu'alors).

Une sonde de poche qui fonctionne au plutonium-238, on connaît, c'est New Horizons avec 478 kg dont 30 d'équipements scientifiques. Et autant dire qu'on ne va pas gagner en passer de 30 kg à une seule caméra. Mais si vous voulez vous mettre en orbite autour d'un objet, il faut beaucoup, beaucoup plus lourd (plus d'une tonne) et donc c'est beaucoup, beaucoup plus cher... ne serait-ce que parce qu'il faut disposer du lanceur idoine, cf. Le projet Persephone d'orbiteur autour de Pluton : https://arxiv.org/abs/2102.08282 : 30 ans de missions, 3 ou 4 tonnes de xénon, des RTG qui n'existent pas encore, lancement obligatoire par un SLS, etc, pour un coût de 3 milliards de dollars.

Donc à mon avis, ça va faire cher la caméra.

-

6

-

1

1

-

-

il y a 30 minutes, jackbauer 2 a dit :Sa masse est estimée à 500 milliards de tonnes

Erreur de traduction à mon avis. Avec une densité de 1, la masse est de un milliard de tonnes par kilomètre cube, donc si la bestiole fait plus de 100 km de long, la volume se compte plus probablement en centaines de milliers de km3, donc centaines de milliers de milliards de tonnes.

-

il y a 54 minutes, FAP a dit :Je me demande si l'allumage périodique du moteur de Webb, afin de le maintenir sur son orbite, ne pourrait pas provoquer un léger réchauffement des instruments du bord ?

Pour les autres satellites "froids" comme Planck, ça n'a jamais été un problème. Par contre, le fait que le carburant s'agite dans les réservoirs quand le satellite subit des accélérations est, je crois, un source de bruit pour la précision de pointage. Et avec la qualité optique du JWST, peut-être que ce sera une problématique plus difficile à gérer que jusque alors.

-

2

-

1

1

-

-

Le 06/04/2022 à 13:03, etoilesdesecrins a dit :Car c'est bien de vouloir balayer devant sa porte (étude faite par un chercheur), mais le risque est de stigmatiser les activités de recherches scientifiques, en éludant totalement les autres commerciales.

Il ne faudrait pas mettre sous l'étiquette "pollution astro" tous les tirs liés à Starlink et autres lancements commerciaux.

D'expérience, c'est plutôt dans le sens inverse que les choses se passent : la puissance publique impose des contraintes à ces agents avant de faire voter un loi pour l'imposer au privé, avec l'antienne "si nous on s'est adaptés, vous aussi". Donc si un jour prochain, on a un truc du genre "nous (fonctionnaires) on a fait notre bilan carbone donc vous (entreprises) devez le faire aussi", ce sera une très bonne chose. Et oui, il faudra changer nos habitudes et ce ne sera pas agréable mais notre empreinte climatique est bien trop insupportable.

Et ce n'est pas une question de stigmatisation. Combien coûte un article scientifique par exemple ? Si on part d'un salaire brut de chercheur de 50000 euros par an, quelques articles par an mais souvent co-écrits avec d'autres auteurs, qu'on ajoute le fonctionnement des labos, les coûts liés à la réalisation de l'article, le chiffre souvent invoqué est 100000 euros, même s'il cache d'énormes disparités (la chiffre est bien moindre en sciences humaines, par exemple). Ce n'est pas rien ! Et à titre personnel, je trouve que cela responsabilise d'avoir le chiffre en tête. Pour ce qui est du bilan carbone, c'est la même chose. Le bilan est globalement plus grand que ce que les chercheurs eux-mêmes imaginent. Prenez un article sur des simulations numériques de quelques centaines de milliers d'heures CPU (pas grand chose, donc). Entre le coût de l'électricité des machines, plus le coût de la climatisation (qui double la facture), selon que vous avez fait vos calculs en France où l'électricité est décarbonée ou alors en Allemagne ou en Australie, le bilan carbone n'est pas du tout le même. Idem en fonction de la saison où le calcul est fait. Mais dans tous les cas, il sera élevé. C'est comme ça. Donc autant le savoir, et autant réfléchir à comment l'atténuer. Est-il indispensable de faire une réunion par mois en présentiel avec des collaborateurs de toute l'Europe ou du monde entier qui vont tous prendre l'avion ? Pas évident. Est-il raisonnable de choisir de de réunir "par habitude" à tel endroit alors que ce réunir ailleurs minimiserait le bilan carbone ? Pas évident non plus. Etc., etc., etc.

Les physiciens des particules connaissent cela depuis des décennies, pas forcément dans la perspective "carbone", mais dans celle "électricité". Le CERN, ou le Tevatron consomment beaucoup, beaucoup d'électricité, résultat les opérations de maintenance se font préférentiellement aux saisons où l'électricité est la plus chère : hiver pour le CERN (car beaucoup de chauffages électriques), et été aux États-Unis (à cause des clims). Mais si l'électricité était gratuite, il serait idiot de ne pas faire le même effort pour l'aspect carbone.Pour ce qui est des satellites des télécommunications, je n'ai pas d'idée du bilan carbone. Quelques milliers de tonnes de CO2 pour le lancement en lui-même, mais le bilan est à répartir sur le nombre final d'utilisateurs. Beaucoup de milliers de tonnes divisées par beaucoup de milliers d'utilisateurs, pas évident de savoir combien cela fait au final. Et je ne sais pas non plus ce qu'on gagne ou qu'on perd en creusant des millions de kilomètres de tranchées pour enterrer des millions de kilomètres de fibres optiques si on préfère faire uniquement des moyens au sol. Si vous voulez savoir ce qui a le meilleur/moins mauvais bilan, eh bien... il faut faire le bilan.

-

4

-

-

il y a une heure, Patrick Sogorb a dit :Drôle de nom ZTF, c'est un programme d'observations?

= Zwicky Transient Facility, un programme d'observation grand champ à l'observatoire du Mont Palomar ayant pour but de détecter des événements transitoires type SN, astéroïdes, étoiles variables, etc., cf. https://www.ztf.caltech.edu/ztf-camera.html

Au passage, c'est typiquement le genre de programme qui est susceptible d'être impacté par les mégaconstellations de satellites du fait de la combinaison grand champ x nombreux clichés. Les participants au programme ont fait un papier récent là-dessus (lien peut-être à mettre dans le fil dédié) : https://arxiv.org/abs/2201.05343

-

1

-

2

2

-

-

Le 10/04/2022 à 08:09, Mister Comets a dit :La comète serait passé à 1,17 UA de Saturne le 29 mai 2020, cette rencontre aurait t'elle pu modifier son orbite initiale ? cela me parait peu probable vu la distance de séparation.

L'idée sous-jacente est la suivante :

- Quand la comète est loin du Soleil, sa trajectoire initiale est parabolique et le foyer est au niveau du barycentre du Système solaire, c'est-à-dire, en première approximation, le barycentre du système Soleil-Jupiter.

- Si la comète à un périhélie "petit" (moins de 1 ua, disons), alors dans la partie interne de sa trajectoire elle est bien plus près du Soleil que de Jupiter, qui se surcroît est peu massive par rapport au Soleil. Le foyer de sa trajectoire est donc désormais le centre du Soleil.

- La transition (progressive) entre la trajectoire loin su Système solaire interne et celle proche du Soleil s'accompagne donc inévitablement d'un changement des paramètres orbitaux, sans qu'il soit nécessaire que la comète passe près d'une planète.

- Or, quand une comète a une trajectoire quasi parabolique, sa vitesse au périastre vp et sa distance au Soleil q sont liées par une relation simple, à savoir vp2 / 2 = G M / q, où G et M sont la constante de gravitation et la masse du Soleil. S'il n'y a plus égalité, l'orbite devient hyperbolique (si le membre de gauche est plus grand que celui de droite) ou elliptique (dans le cas contraire).

- L''écart en distance entre le centre du Soleil et le barycentre du Système solaire est de l'ordre d'un rayon solaire. L'ordre de grandeur de la variation de la distance au périastre est donc de cet ordre, et n'est pas ridicule par rapport à la distance au périastre (1/200 pour un périastre à 1 ua)

- Ceci suffit largement pour l'égalité vp2 / 2 = G M / q ne prévale pas et que la comète ne soit plus sur une orbite parabolique. Si q augmente, la trajectoire devient hyperbolique, si il diminue, elle devient elliptique.

- On pourrait dire que l'effet inverse se produit quand la comète sort de la région interne de sa trajectoire, mais Jupiter aura bougé entre temps. Les deux perturbations (à l'entrée et à la sortie de la portion la plus interne de sa trajectoire) n'ont donc aucune raison de se compenser.

- Bien évidemment, si en prime la comète passe devant une planète géante, sa trajectoire subira une autre perturbation mais ça n'est pas indispensable pour que sa nature change.

Bien évidemment aussi, la réalité est plus complexe que le modèle naïf ci-dessus et malheureusement il n'existe pas de formule simple qui explique comment les paramètres orbitaux vont changer. Il faut faire au cas par cas.

-

2

-

8

8

-

Il y a 7 heures, Superfulgur a dit :est ce que ça n'en fait pas une cible idéale pour l'imagerie ???

Il suffit de comparer avec M87*. Si la perte qu'on a en terme de masse (de 6,5 à 2 milliards de masses solaires) est compensée par un gain en distance (50 vs. 30 millions d'al), la réponse serait oui, mais même avec 2 milliards de masses solaires on est nettement en-dessous de M87*, en gros d'un facteur 2. Autrement dit, l'image de M104* va être au mieux deux fois plus floue que celle de M87*, sachant que j'ai un (gros) doute sur ce chiffre de 2 milliards de masses solaires. Il y a quelques années, on parlait plutôt de 1 milliard max (cf. https://arxiv.org/abs/1601.00974), ce qui ferait une silhouette de 10 ou 12 microsecondes d'arc, soit 4 fois plus petit que M87*. Autant dire qu'on ne verrait pas grand chose.

À noter aussi que en interférométrie on est assez sensible à la magnitude de surface de l'objet. Si elle est trop faible, cela dégrade encore plus l'image N'ayant pas entendu dire que M104* est particulièrement actif, il n'est pas à exclure que cela dégrade l'image d'autant. C'est un point qui est rarement évoqué : pour voir des détails aussi fins, il faut que la zone étudiée possède une brillance de surface d'autant plus grande. C'est bien sûr assez logique : si vous zoomez d'un facteur 2 sur une image, vous répartissez les photons reçus sur une surface 4 fois plus grande. Donc si le truc n'est pas brillant, au bout d'un moment on zoome sur du noir, et l'image est noire. Ce n'est que parce que les disques d'accrétion ont une brillance de surface monstrueuse en radio qu'on peut voir quelque chose. C'est la raison pour laquelle il n'est pas évident de savoir ce que l'on peut faire d'autre avec l'EHT : il y a des tas de cibles intéressantes à étudier à très haute résolution angulaire, encore faut-il qu'elles brillent assez, ce qui ne doit pas être aussi souvent le cas qu'on aimerait.

-

3

-

5

5

-

-

Il y a 9 heures, universocean a dit :Eh bien, les TN sont au cœur du modèle JANUS, c'est dans le titre de la présentation de la vidéo.

Le modèle que vous citez est l'oeuvre d'un homme vieillissant qui même plus jeune ne comprenait rien à la relativité. Ce modèle parle, à la rigueur, des ravages de l'âge et des complexes de supériorité que présentent souvent les génies autoproclamés. Il ne parle pas de physique ou d'astrophysique.

Si vous voulez discuter de cela, ouvrez un fil dédié, mais de grâce, ne polluez pas un fil scientifique sérieux avec cela.

-

5

-

1

1

-

1

1

-

-

Il y a 4 heures, Bruno- a dit :Ce que j'ai appelé la distance initiale n'a pas de sens : nous n'existions pas au moment de l'émission de la lumière de cette étoile.

Ce que j'ai appelé la distance finale n'a pas de sens : cette étoile n'existe plus au moment où nous recevons sa lumière.

Surtout, ce sont des distances définies à temps constant, alors que nous vivons dans un espace-temps en expansion. La distance entre une étoile qui n'existe plus aujourd'hui et nous qui n'existions pas à l'époque où cette étoile existait ne peut être qu'une distance dans l'espace temps, enter deux objets ayant des coordonnées spatiales différentes mais aussi des coordonnées temporelles différentes. La distance luminique joue ce rôle et tout le monde la comprend.

Pardon, mais c'est beaucoup de blabla pour pas grand chose. Si on veut être rigoureux, on dira que la distance spatiotemporelle entre deux points de la trajectoire d'un photon est... nulle. Toujours. Ladite distance spatio temporelle au carré, ce n'est rien d'autre que la distance parcourue par le photon entre les deux points (déterminée une fois un système de coordonnées choisi), mise au carré, et à laquelle on soustrait le temps de trajet (déterminé dans le même référentiel) multiplié par c et mis au carré. Ce 0 est le seul truc intrinsèque lié à votre photon (= on trouve toujours 0, quel que soit le référentiel utilisé, qui ne sert donc que d'intermédiaire de calcul).

Si vous voulez défendre l'idée que le temps de trajet a plus de sens que la distance, vous allez vite être coincé car dans l'un ou l'autre des cas, vous devez choisir un référentiel (ou, disons, un système de coordonnées car on est en relativité générale, pas en relativité restreinte) et faire des calculs dans ce système de coordonnées. Mais c'est exactement ce que vous faites si vous raisonnez en terme de distance. C'est vraiment pareil : vous considérez le même système de coordonnées. Il est donc tout aussi licite de raisonner en terme de distance ou de durée. La question qui se pose est de savoir ce que l'on conceptualise le plus. La Galaixe d'Andromède est à 2,2 millions d'années-lumière. Je peux le conceptualiser, car je vois effectivement la galaxie en question. Elle a émis sa lumière il y a 2,2 millions d'années. Puis-je conceptualiser une telle durée ? Si on raisonne en terme de générations ( j'ai des enfants à 25 ans, qui eux-même auront des enfants à 25 ans, et ainsi de suite, 2,2 millions d'années, c'est 88000 générations. Peut-on concevoir cela ? Pas sûr. C'est un paradoxe connu depuis l'Antiquité, en fait : on "voit" des distances très grandes (celles des étoiles, même si en ce temps on ne sait à quelle distance elles sont), mais on ne peut pas percevoir les durées et encore moins les conceptualiser (cf. la chronologie biblique...). Donc pourquoi pas raisonner avec des durées, mais ça n'est ni plus concret ni plus simple ni plus naturel, ni plus ceci ou cela qu'utiliser des distances. Votre terme de "distance luminique" n'a aucun sens physique à mon avis (autre que celui que vous lui donnez).

L'avantage qu'il y a avec les durées, c'est qu'on peut dire les choses de façon plus concise : "la lumière que nous recevons de cette étoile a été émise quand l'Univers avait X milliards d'années", c'est plus court et plus agréable à lire que "la région où si situait l'étoile quand elle a émis sa lumière était située à Y milliards d'années-lumière de la région où le Soleil se formerait plus tard, et aujourd'hui ces deux régions sont situées à Z milliards d'années (avec Y < X < Z). Les anglo-saxons ont même inventé le terme de "lookback time" pour cela, ce qui simplifie encore la formulation. Notez quand même que c'est un énorme coup de chance : si l'Univers n'est pas homogène et isotrope, vous avez autant de temps que d'observateurs, donc cela n'aurait vraiment aucun sens de dire que la lumière a voyagé 12,9 milliards d'années si on ne précise pas comment on mesure cette durée (et ce sera très compliqué de le faire). Le fait qu'il y ait un temps cosmique qu'on puisse définir partout à l'identique (il existe une relation valable partout entre, disons, la température du fond diffus cosmologique et le temps écoulé depuis, disons, la nucléosynthèse) est un hasard heureux. À l'inverse, parler uniquement de durée glisse sous le tapis les subtilités liées à l'expansion : par exemple qu'un objet à très grand redshift était en fait très proche au moment où il a émis sa lumière. L'exemple canonique est le fond diffus cosmologique : la région qui a émis le fond diffus que nous captons aujourd'hui était, à l"époque, plus proche de nous que ne l'est M87 aujourd'hui alors qu'elle est aujourd'hui 1000 fois plus éloignée que M87. Si vous dites juste que le fond diffus a été émis il y a 13,8 milliards d'années, ou " il y a longtemps", on peut s'imaginer que la région en question a toujours été loin, ce qui est faux : à trop raccourcir le propos, on finit par masquer la complexité et, ce qui est pire, donner à croire qu'elle n'existe pas.

J'ajoute que le chiffre de 12,9 milliards d'années, vous ne le connaissez pas a priori. Ce que vous mesurez directement, c'est le redshift et la magnitude. Ce sont les seules quantités mesurables de façon directe. Si vous voulez passer de ces deux quantités à la distance entre les deux zones (en précisant l'époque où vous la définissez) ou la durée du trajet, vous devez connaître l'histoire de l'expansion et donc le contenu matériel de l'Univers. À supposer que vous les connaissiez (mais votre observation ne vous suffira pas, loin de là), vous avez tout ce qu'il faut pour déterminer à la fois la durée et les distance en question. Là encore, l'un des concepts n'est pas privilégié par rapport à l'autre : soit vous avez les deux, soit aucun.

Pour la route, et tant qu'à faire :

Il y a 2 heures, Bruno- a dit :Par exemple si on voulait, là, maintenant, rendre visite à cette étoile, enfin, à ce bout d'espace-temps pour voir ce qu'il est devenu, même avec un engin se déplaçant à la vitesse de la lumière, il faudrait beaucoup plus de 28 milliards d'années vu que l'espace continuera à gonfler durant le trajet...

En fait, vous ne pourrez purement et simplement pas. Du fait que l'expansion est accélérée, vous ne pourrez jamais franchir une telle distance car la région où se trouve cette étoile s'éloigne de nous déjà trop vite pour pouvoir la combler, même à la vitesse de la lumière. Même des objets qui sont seulement à un redshift de 1 et quelque sont déja trop loin pour qu'on puisse les atteindre désormais. C'est encore plus vrai pour des redshifts supérieur à 5 ou 6, du moins si l'expansion accélérée que nous connaissons perdure indéfiniment, ce dont aucune observation ne peut nous assurer.

-

2

-

4

4

-

-

Il y a 9 heures, jackbauer 2 a dit :Des calculs qui semblent tirés par les cheveux... Mais apparemment certains sont en quête de vertu...

C'est juste une obligation légale qui va arriver à plus ou moins court terme que de réfléchir à diminuer son empreinte carbone. Cela fait des années que toutes les administrations en France sont incitées à faire cela. Moins de réunions en présentiel, moins d'avion quand cela est possible, moins d'usage des centres de calculs dans les pays dont l'électricité n'est pas décarboné, etc., etc., etc. S'imaginer que parce qu'on est chercheur on aura droit à un permis de polluer sans limite, ça n'arrivera pas.

-

1

-

-

Il y a 17 heures, jackbauer 2 a dit :Toujours Spitzer/Webb :

Avec un rapport de taille de miroir (85 cm vs. 6,5m) on gagne entre 7 et 8 en terme de résolution pour des observations à même longueur d'onde. Si l'image de calibration du JWST est à une longueur d'onde plus courte que 3,6 microns, on gagne encore. Il me semble que la gamme de longueur d'onde de NIRCAM est, au choix, de 0,6 à 2,3 microns ou 2,4 à 5. Donc si on suppose que c'est dans le premier intervalle qu'ont été faites les images montées, on gagne encore un facteur 1,5, donc dans les 10 ou 12 en tout.

À cela s'joutent des détecteurs plus sensibles, moins bruités, etc.

-

4

-

-

(remarque naïve effacée)

-

Il y a 3 heures, Huitzilopochtli a dit :longueurs d'onde du cadre de repos (!?...)

"frame" = "cadre", mais aussi, dans ce contexte, "référentiel"

du cadre de repos = (je suppose) "rest frame" = le référentiel au repos par rapport à la matière étudiée (à l'inverse du référentiel des galaxies emportées par l'expansion).

-

4

4

-

-

Il y a 18 heures, Astrotaupe88 a dit :A quoi correspond les 6 grandes branches de l'étoile et les 2 plus petites, le support du secondaire ?

Diffraction par un miroir hexagonal = étoile à six branches a priori. Il faudrait aussi voir la forme exacte du secondaire et de son support pour voir ce qui s’y rajoute.

-

3

-

2

2

-

Pourquoi les météorites ne sont-elles pas satellisées par la terre ?

dans Astronomie générale

Posté(e)

On ne sait pas. L'orbite circulaire et équatoriale des satellites ne plaide pas pour une capture, mais les propriétés spectroscopiques les font beaucoup ressembler à des astéroïdes, donc on a des arguments plutôt convaincants... en faveur de chacune des hypothèses. J'imagine qu'une mission de retour d'échantillon comme MMX sera en mesure de trancher.